Crédit: Flickr/cc/Murdocke23

Informations, vitesse et précipitation

L’immense majorité des problématiques techniques tournant autour d’Internet portent sur les débits ou les temps de téléchargement. Il fut un temps pas si lointain où l’on parlait de connexions en 56k, alors que nous sommes aujourd’hui dans l’ère du 100Mo/seconde, voire plus encore. Cette évolution basée sur la vitesse accompagne et encourage le développement des flux d’information dont la nature – du peer to peer au téléchargement direct en passant par le streaming – est désormais très diversifiée. Mais le culte de la vitesse s’est progressivement étendu des contenants vers les contenus : la vitesse de mise en ligne de l’information est devenue une priorité pour les rédactions. Si, auparavant, il fallait attendre l’impression du journal pour publier un scoop, Internet permet désormais de le faire instantanément, quitte à aller parfois trop vite. Médias et réseaux sociaux évoluent désormais dans une instantanéité préjudiciable autant à la qualité de l’information qu’à son simple rapport à la vérité ou à la réalité. Comme le souligne très justement un blogueur sur Rue89, « le problème posé par la profusion des contenus sur Internet, c’est celui du filtrage et de la hiérarchisation des contenus : qui vérifie l’information ? Qui sert de référence ? »

La question n’est pas près de trouver une réponse, parce qu’Internet permet justement un anonymat quasi complet. Alliée aux capacités de diffusion des réseaux sociaux et sites d’informations, cette spécificité fait du web un espace de liberté d’une portée sans commune mesure avec tout ce qui a pu se faire précédemment. Du temps de la presse papier dominante, un article est signé et engage son auteur, ou au moins sa ligne éditoriale, en dehors des canulars du 1er avril. Internet permet d’échapper à cette responsabilité par rapport aux contenus. C’est une des raisons pour laquelle prolifèrent sur Internet les hoax, ces rumeurs tenaces ou simples « légendes urbaines », dont l’origine et la finalité restent souvent très mystérieuses.

Le hoax est une intoxication, une fausse information, parfois très élaborée, dont le but premier est de se diffuser le plus largement possible de façon virale. A priori sans dangers particuliers, il a simplement le mérite de nous inciter à la prudence par rapport aux contenus auxquels nous avons accès. Il existe même des sites spécialisés, indépendants ou institutionnels, ayant pour vocation de les identifier et de les référencer. Mais le hoax n’est que la pointe de l’iceberg, tant la difficulté est grande d’évaluer la fiabilité d’une source et la véracité d’une information, même au sens le plus général que l’on puisse donner à ces critères. Particulièrement dans le monde médiatique, qui a le temps de vérifier, contrôler, confirmer, ou recouper une information ? Les informations les plus intéressantes (les « scoops ») sont généralement tirées d’une source unique, impossible à vérifier dans les délais que permet le tempo médiatique. Même les agences de presse sont parfois intoxiquées par des canulars… quand elles ne se font pas purement ou simplement pirater, se voyant ainsi réduites au rang de simples caisses de résonnance.

La question n’est pas près de trouver une réponse, parce qu’Internet permet justement un anonymat quasi complet. Alliée aux capacités de diffusion des réseaux sociaux et sites d’informations, cette spécificité fait du web un espace de liberté d’une portée sans commune mesure avec tout ce qui a pu se faire précédemment. Du temps de la presse papier dominante, un article est signé et engage son auteur, ou au moins sa ligne éditoriale, en dehors des canulars du 1er avril. Internet permet d’échapper à cette responsabilité par rapport aux contenus. C’est une des raisons pour laquelle prolifèrent sur Internet les hoax, ces rumeurs tenaces ou simples « légendes urbaines », dont l’origine et la finalité restent souvent très mystérieuses.

Le hoax est une intoxication, une fausse information, parfois très élaborée, dont le but premier est de se diffuser le plus largement possible de façon virale. A priori sans dangers particuliers, il a simplement le mérite de nous inciter à la prudence par rapport aux contenus auxquels nous avons accès. Il existe même des sites spécialisés, indépendants ou institutionnels, ayant pour vocation de les identifier et de les référencer. Mais le hoax n’est que la pointe de l’iceberg, tant la difficulté est grande d’évaluer la fiabilité d’une source et la véracité d’une information, même au sens le plus général que l’on puisse donner à ces critères. Particulièrement dans le monde médiatique, qui a le temps de vérifier, contrôler, confirmer, ou recouper une information ? Les informations les plus intéressantes (les « scoops ») sont généralement tirées d’une source unique, impossible à vérifier dans les délais que permet le tempo médiatique. Même les agences de presse sont parfois intoxiquées par des canulars… quand elles ne se font pas purement ou simplement pirater, se voyant ainsi réduites au rang de simples caisses de résonnance.

Le critère de pertinence

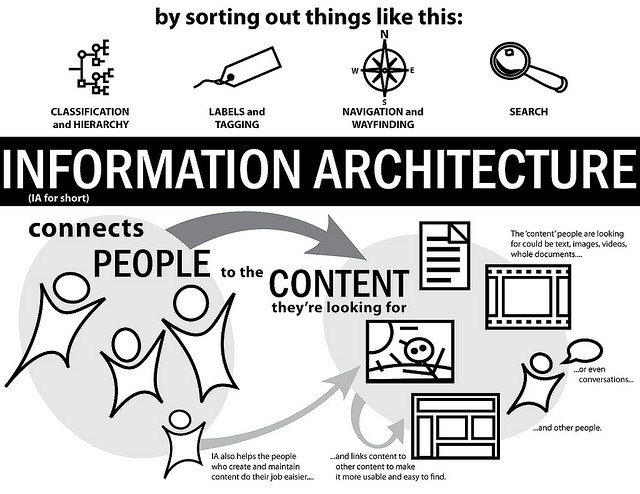

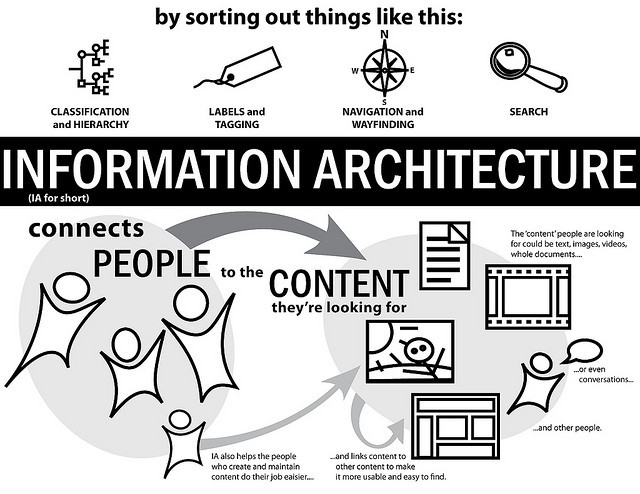

Selon les estimations de la World Wide Web Fondation, Internet serait composé d’environ 1000 milliards de pages web. Les moteurs de recherche se sont donc imposés depuis longtemps comme une nécessité. Mais il ne référence qu’une partie du web : le web visible. Le reste, bases ou banques de données, bibliothèques en ligne gratuites ou payantes… correspond au web invisible, appelé aussi hidden web ou deep web. Le web invisible serait aussi des centaines de fois plus volumineux que le web visible. En compilant ces deux éléments, on se rend compte que les moteurs de recherche ne nous donnent accès qu’à une infime partie de l’information disponible, mais que c’est déjà trop. De plus les algorithmes de recherche à la base du moteur le plus utilisé ne prennent pas en compte le contenu, mais la « popularité » de la page, en termes de nombre de liens, pour la classer. C’est ce qu’on appelle le page-ranking, et dans cette logique, peu importe la teneur de la page pour le logiciel.

Mais on ne pourra pas se passer longtemps d’une réflexion sur les contenus. La logique qui prévaut actuellement a, entre autres, pour conséquence de compromettre toute tentative de contrôle d’accès lors des recherches. Or cela présente des risques pour le jeune public notamment, qui, et c’est heureux en un sens, se familiarise avec internet de plus en plus tôt. Certains éditeurs de contenus s’en alarment à raison : « comment pourrions-nous laisser les choix de lecture de nos enfants dans les mains de moteurs de recherche aux algorithmes incontrôlables, ou de réseaux sociaux tout juste capables de répéter et amplifier les succès fabriqués ? », interroge ainsi Arnaud Nourry, PDG des éditions Hachette, lors des 20 ans du Forum du Livre. Les éditeurs ont par nature cette culture de la sélection et de la qualité parce que c’est inhérent à leur fonction. François Gèze, PDG des éditions La Découverte, ne voit pas les choses autrement : « être éditeur, c’est jouer le rôle de passeur entre des personnes, qui produisent des idées ou créent des fictions, et des lecteurs qui trouvent utilité ou plaisir à lire ces travaux. Ce cœur de métier — choisir et faire connaître – est resté le même ».

L’éditeur est un intermédiaire qui choisit. C’est précisément ce qui manque aujourd’hui sur internet : non pas le choix, mais la sélection, la distinction, la hiérarchisation. Certains moteurs de recherche, avec des diffusions nettement plus confidentielles que le leader incontesté du marché, utilisent des algorithmes fondés sur la pertinence. Mais on peut légitimement se demander dans quelle mesure la pertinence peut être mise en équation. À défaut de disposer d’une armée d’éditeurs effectuant un travail de tri en ligne, le moteur de recherche qui proposera un tel service de manière satisfaisante sera probablement le prochain grand succès des mondes virtuels. D’ici là, l’information de qualité risque de disparaitre, non qu’elle n’existera plus, mais parce qu’elle risque de disparaitre noyée sous un flot d’informations inutiles, erronées, ou redondantes.

Mais on ne pourra pas se passer longtemps d’une réflexion sur les contenus. La logique qui prévaut actuellement a, entre autres, pour conséquence de compromettre toute tentative de contrôle d’accès lors des recherches. Or cela présente des risques pour le jeune public notamment, qui, et c’est heureux en un sens, se familiarise avec internet de plus en plus tôt. Certains éditeurs de contenus s’en alarment à raison : « comment pourrions-nous laisser les choix de lecture de nos enfants dans les mains de moteurs de recherche aux algorithmes incontrôlables, ou de réseaux sociaux tout juste capables de répéter et amplifier les succès fabriqués ? », interroge ainsi Arnaud Nourry, PDG des éditions Hachette, lors des 20 ans du Forum du Livre. Les éditeurs ont par nature cette culture de la sélection et de la qualité parce que c’est inhérent à leur fonction. François Gèze, PDG des éditions La Découverte, ne voit pas les choses autrement : « être éditeur, c’est jouer le rôle de passeur entre des personnes, qui produisent des idées ou créent des fictions, et des lecteurs qui trouvent utilité ou plaisir à lire ces travaux. Ce cœur de métier — choisir et faire connaître – est resté le même ».

L’éditeur est un intermédiaire qui choisit. C’est précisément ce qui manque aujourd’hui sur internet : non pas le choix, mais la sélection, la distinction, la hiérarchisation. Certains moteurs de recherche, avec des diffusions nettement plus confidentielles que le leader incontesté du marché, utilisent des algorithmes fondés sur la pertinence. Mais on peut légitimement se demander dans quelle mesure la pertinence peut être mise en équation. À défaut de disposer d’une armée d’éditeurs effectuant un travail de tri en ligne, le moteur de recherche qui proposera un tel service de manière satisfaisante sera probablement le prochain grand succès des mondes virtuels. D’ici là, l’information de qualité risque de disparaitre, non qu’elle n’existera plus, mais parce qu’elle risque de disparaitre noyée sous un flot d’informations inutiles, erronées, ou redondantes.

Entreprise

Entreprise